Ferramentas para gerar e validar um Arquivo Robots.txt

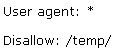

De posse destas informações, podemos ter noção da seriedade que devemos dar a estrutura de um arquivo Robot.txt. Caso não tenha certeza de que tudo esteja correto você pode utilizar uma ferramenta de revisão e validação como a encontrada em http://tool.motoricerca.info/robots-checker.phtml. Esta ferramenta detectada e informa sobre erros comuns ocorridos no arquivo robot.txt, poupando seus esforços. Por exemplo, caso seja digitado:

A descrição deste arquivo está errada porque não há nenhum hífen entre "User" e "agent", sendo uma sintaxe incorreta.

Em alguns casos, quando temos um arquivo Robots.txt complexo; escrever o arquivo Robot.txt manualmente pode ser um grande problema, por exemplo: quando temos diferentes instruções para determinados tipos de User agents ou temos uma lista longa de diretórios e subdiretórios para exclusão.

> Existem diversas formas de se realizar esta tarefa, inclusive ferramentas (softwares) que podem gerar o arquivo Robot.txt para você. E mais ajuda ainda, existem ferramentas visuais que permitem apontar e selecionar quais arquivos e diretórios devem ser excluídos em seu arquivo.

No caso de não querer adquirir um software/ferramenta gráfica para a geração de arquivos Robots.txt também existem ferramentas on-line para ajudá-lo.

Por exemplo, o Server-Side Robots Generator http://www.submitcorner.com/Tools/Robots/server.shtml oferece uma lista dropdown de agentes operadores e uma caixa de texto para você escolher os arquivos que não deseja indexar. Honestamente, pode não ser muita ajuda a menos que você requeira regras específicas para diferentes sistemas de Busca, mas não deixa de ser uma boa ajuda.