Estrutura de um Arquivo de Robots.txt

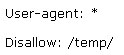

A estrutura de um arquivo Robots.txt é bastante simples (e um pouco flexível também) e pode existir uma listagem interminável de user agents, diretórios e arquivos desabilitados. Basicamente, a sintaxe é a seguinte:

"User-agent" são os crawlers dos motores de Busca e disallow: lista os arquivos e diretórios a serem excluídos da indexação. Além de "User-agent:" e "disallow:" você podem incluir linhas de comentário utilizando o sinal # no começo da linha, ex. :

# Todos User-agents estão desabilitados a verem o diretório temporário: /temp/.

As possíveis armadilhas de um arquivo Robots.txt

Ao tentar aumentar a complexidade de um arquivo robots.txt devemos tomar muito cuidado - ex. : decidir permitir que diferentes "User-agent" tenham acesso a determinados diretórios e outros não - os problemas podem começar por aqui, se você não der atenção especial às armadilhas que um arquivo Robots.txt pode causar.

Os erros mais comuns são os de digitação e diretrizes contraditórias. Erros na digitação de caracteres e forma errada de identificação dos User-agents, diretórios, ausência de pontuação após User-agent, Disallow e etc.

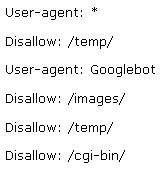

Alguns erros de digitação podem ser difíceis de serem encontrados, mas existem algumas ferramentas de validação que podem ajudar nestes casos.O problema mais sério ocorre com erros lógicos. Por exemplo:

O exemplo acima é de um arquivo Robots.txt que na realidade permite que todos User-agent acessem todo o site exceto o diretório /temp/.

Até aqui tudo bem mas logo a seguir existem outros registros que especificam termos mais restritivos para o Googlebot. Quando o robot Googlebot inicia a leitura do arquivo Robots.txt verá que todos User-agents (incluindo Googlebot) estão permitidos a terem acesso a todos os arquivos e diretórios exceto o diretório /temp/. Isto já é o suficiente para informar o Googlebot sobre o que deve ser feito, então o arquivo não será lido até o fim e vai ser feito o rastreio em todo o índice do site exceto o diretório /temp/ - e incluindo automaticamente os diretórios /imagens/ e /cgi-bin/ que provavelmente não era a intenção.

Como pode ver, na estrutura de um arquivo Robots.txt podem ocorrer facilmente sérios erros.

Ferramentas para gerar Robots.txt >>>